Разработаны новые алгоритмы «прозрачного» ИИ

Разработаны новые алгоритмы «прозрачного» ИИ

Современные системы искусственного интеллекта, основанные на машинном обучении, используют непонятные человеку алгоритмы принятия решений. Эта «непрозрачность» вызывает недоверие и опасения. Сотрудники Института теоретической и экспериментальной биофизики РАН и Института биофизики клетки РАН разработали и реализовали новые алгоритмы «прозрачного» ИИ, которые понятны человеку, надёжны и безопасны. Разработка включает новые принципы создания ИИ, открытый код разработанных программ и относится к области символического ИИ.

Символический ИИ специализируется на основе прямого использования логики и человеческих знаний. Этот подход доминировал с середины 1950-х до конца 1980-х годов. Потом оказалось, что перед его широким использованием стоит ряд непреодолимых проблем: непрозрачность используемых математических моделей, неоднозначность терминов естественного языка, непреодолимый комбинаторный взрыв, возникающий при полном переборе возможных вариантов в поисках наилучшего решения. Такой перебор может потребовать больше времени, чем время тепловой смерти нашей Вселенной.

Учёные из ИТЭБ РАН и ИБК РАН разработали алгоритм, который преодолевает перечисленные препятствия. Исследование прокомментировал научный сотрудник ИТЭБ РАН Лев Калмыков: «Созданный логически прозрачный искусственный интеллект реализует автоматический логический вывод одновременно на трёх уровнях организации сложной системы, учитывая локальные зависимости её микрообъектов. Онтологической основой „прозрачного“ ИИ служит аксиоматическая теория соответствующей предметной области, а инструментальной основой являются логические клеточные автоматы. С помощью разработанного символического ИИ нами проверены формулировки принципа конкурентного исключения, гипотеза лимитирующего сходства, гипотеза лимитирующего различия, решён парадокс биоразнообразия, найдены новые механизмы сосуществования, исследован механизм квазисолитонного прохождения популяционных автоволн. Реализованный вариант символического ИИ основан на полностью прозрачных алгоритмах и имеет природу белого ящика. Этим он принципиально отличается от современного генеративного ИИ, реализованного на непрозрачных алгоритмах, имеющих природу чёрного ящика».

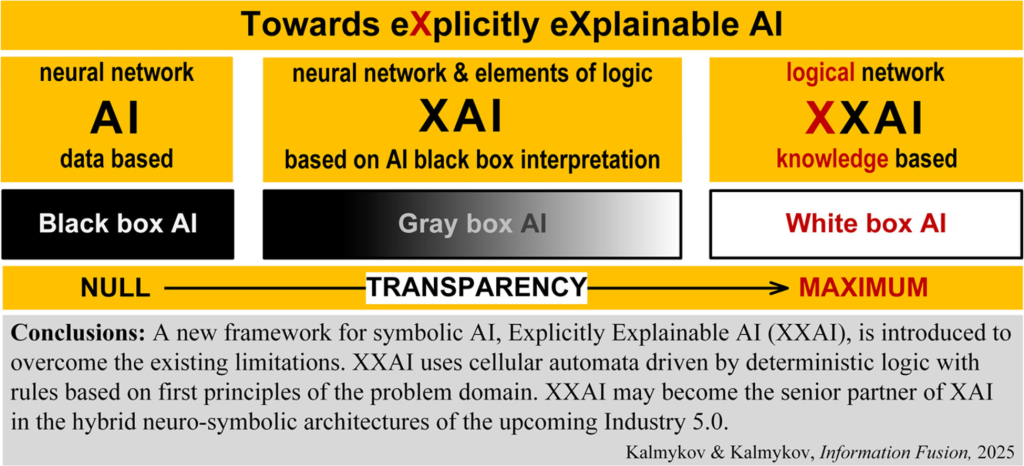

Попытки решить проблему чёрного ящика современного ИИ известны как программа «Объяснимого ИИ» Управления перспективных исследовательских проектов Министерства обороны США (DARPA) 2016 года — eXplainable Artificial Intelligence (XAI). Хотя результаты программы XAI& помогли частично интерпретировать работу чёрного ящика нейронных сетей, они не изменили их первоначальную «непрозрачную» статистическую природу и неопределенность в отношении безопасности и надежности принимаемых решений. Разработанный в Пущино новый метод ИИ полностью преодолевает проблему чёрного ящика ИИ, что отражено в названии предлагаемого подхода — eXplicitly eXplainable Artificial Intelligence (XXAI). Эксплицитно — явно, прямо, однозначно.

Представляемый подход использован авторами для автоматической проверки экологических гипотез, но их работа закладывает методологическую основу для программы исследований и разработок по созданию символического ИИ общего назначения. Авторы предлагают использовать разработанный «прозрачный» ИИ в качестве старшего партнёра «непрозрачного» генеративного ИИ в будущих гибридных решениях ИИ так, как это реализовано в функционально асимметричном мозге человека, в котором левое логическое полушарие контролирует образные и инстинктивные решения, принимаемые правым полушарием.

Результаты исследования опубликованы в статье в журнале Information Fusion. Доступ к открытому коду в публикациях авторов в Academic Biology и в Chaos, Solitons & Fractals.

Источник: пресс-служба ИТЭБ РАН.